En 2014, des chercheurs du MIT (Massachusetts Institute of Technology) ont conçu une expérience appelée « Moral Machine. » L’idée était de créer une plateforme semblable à un jeu qui permettrait de recueillir les décisions des gens sur la façon dont les voitures autonomes devraient donner la priorité aux vies humaines dans différentes variantes du « Dilemme du tramway. » Ce faisant, les données générées donneraient un aperçu des priorités éthiques collectives des différentes cultures.

Les chercheurs n’avaient pas prévu la réception virale de l’expérience. Quatre ans après la mise en service de la plateforme, des millions de personnes dans 233 pays et territoires ont enregistré 40 millions de décisions, ce qui en fait l’une des plus grandes études jamais réalisées sur les préférences morales à l’échelle mondiale.

Un article publié dans la revue Nature présente l’analyse de ces données et révèle à quel point l’éthique diverge en fonction de la culture, de l’économie et de la situation géographique.

Le « dilemme du tramway » est le suivant: Vous voyez un tramway qui s’emballe sur les rails, sur le point de percuter et de tuer cinq personnes. Vous avez accès à un levier qui pourrait faire passer le tramway sur une autre voie, où une autre personne connaîtrait alors une fin prématurée. Devriez-vous tirer le levier et mettre fin à une vie pour en épargner cinq?

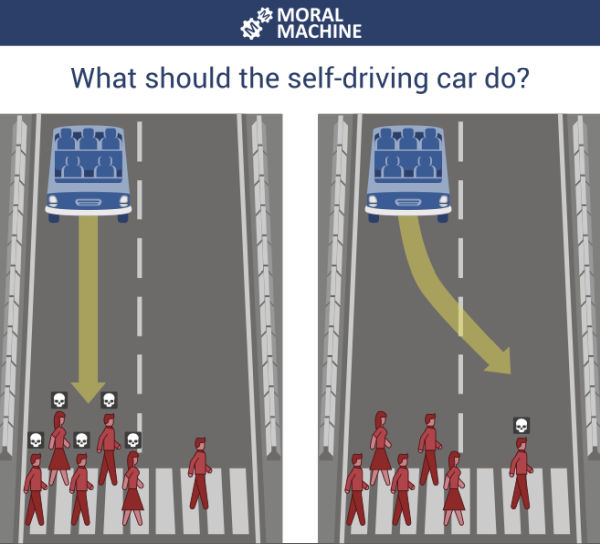

La Moral Machine a repris cette idée pour tester neuf comparaisons différentes dont on sait qu’elles polarisent les gens: une voiture autonome devrait-elle donner la priorité aux humains sur les animaux domestiques, aux passagers de la voiture sur les piétons, à plus de vies sur moins de vies, aux femmes sur les hommes, aux jeunes sur les vieux, aux personnes en bonne santé sur les malades, à un statut social plus élevé par rapport à un statut social plus bas, à ceux qui respectent la loi par rapport aux contrevenants à la loi? Enfin, la voiture doit-elle faire une embardée (action) ou rester sur sa trajectoire (inaction)?

Exemple de question posée aux participants de la Moral Machine.

Cependant, plutôt que d’établir des comparaisons un à un, l’expérience a présenté aux participants diverses combinaisons, par exemple si une voiture autonome devait continuer tout droit pour tuer trois piétons âgés ou faire une embardée dans une barricade pour tuer trois jeunes passagers.

Les chercheurs ont constaté que les préférences des pays différaient considérablement, mais qu’elles étaient aussi fortement corrélées à la culture et à l’économie. Par exemple, les participants issus de cultures collectivistes comme la Chine et le Japon sont moins enclins à épargner les jeunes plutôt que les personnes âgées, peut-être, selon l’hypothèse des chercheurs, parce qu’ils accordent plus d’importance au respect des personnes âgées. A l’inverse, les pays ayant une culture plus individualiste comme la France sont plus susceptibles d’épargner les jeunes. Dit autrement, en Chine les gens préfèrent sauver la grand-mère et en France les gens préfèrent sauver le bébé…

Concernant le choix entre privilégier la vie des passagers de la voiture ou la vie des piétons, il est intéressant de constater un grand écart entre la Chine (qui privilégie la vie des passagers) et le Japon (qui privilégie la vie des piétons), la France étant en l’occurrence ici plutôt dans la moyenne…

De même, les participants originaires de pays plus pauvres et dotés d’institutions plus faibles sont plus tolérants à l’égard des piétons qui traversent en dehors des clous par rapport aux piétons qui traversent légalement. Enfin, les participants originaires de pays où les inégalités économiques sont fortes présentent des écarts plus importants entre le traitement des personnes de statut social élevé et celui des personnes de statut social faible.

Enfin, en ce qui concerne la question essentielle du dilemme des tramways, les chercheurs ont constaté que le nombre de personnes en danger n’était pas toujours le facteur déterminant dans le choix du groupe à épargner. Les résultats ont montré que les participants issus de cultures individualistes, comme la France, le Royaume-Uni et les États-Unis, privilégiaient davantage la protection d’un plus grand nombre de vies, compte tenu de tous les autres choix possibles, peut-être, selon les auteurs, en raison de l’importance plus grande accordée à la valeur de chaque individu. On peut noter au passage que dans le cadre de cette étude, la France apparaît comme un pays particulièrement individualiste…

Les pays proches les uns des autres ont également montré des préférences morales plus marquées, avec trois groupes dominants à l’ouest, à l’est et au sud.

Les chercheurs reconnaissent que les résultats pourraient être faussés, étant donné que les participants à l’étude étaient auto-sélectionnés et donc plus susceptibles d’être connectés à l’internet, d’avoir un statut social élevé et d’être à l’aise avec la technologie. Mais les personnes intéressées par les voitures autonomes devraient également présenter ces caractéristiques.

L’étude a des implications intéressantes pour les pays qui testent actuellement des voitures autonomes, car ces préférences pourraient jouer un rôle dans la conception et la réglementation de ces véhicules. Les constructeurs automobiles pourraient constater, par exemple, que les consommateurs chinois seraient plus enclins à monter dans une voiture qui les protégerait contre les piétons.

Mais les auteurs de l’étude ont souligné que les résultats ne sont pas censés dicter la manière dont les différents pays doivent agir. En fait, dans certains cas, les auteurs estiment que les technologues et les décideurs politiques devraient prendre le pas sur l’opinion publique collective. Edmond Awad, l’un des auteurs de l’article, a cité en exemple la comparaison du statut social. « Il semble inquiétant que les gens aient trouvé normal, dans une large mesure, de privilégier un statut social supérieur par rapport à un statut inférieur, » a-t-il déclaré. Selon lui, les résultats devraient être utilisés par l’industrie et le gouvernement comme base pour comprendre comment le public réagirait à l’éthique de différentes décisions en matière de conception et de politique.

M. Awad espère que les résultats aideront également les technologues à réfléchir plus en profondeur à l’éthique de l’IA au-delà des voitures autonomes. « Nous avons utilisé le dilemme des tramways parce que c’est un très bon moyen de collecter ces données, mais nous espérons que la discussion sur l’éthique ne se limitera pas à ce thème, » a-t-il déclaré. La discussion devrait s’orienter vers l’analyse des risques – pour savoir qui court plus ou moins de risques – au lieu de dire qui va mourir ou non, et aussi sur la façon dont les biais se produisent. Il espère pouvoir étudier plus avant la manière dont ces résultats pourraient se traduire par une conception et une réglementation plus éthiques de l’IA.

« Au cours des deux ou trois dernières années, de plus en plus de gens ont commencé à parler de l’éthique de l’IA, » a déclaré M. Awad. « Davantage de personnes ont commencé à prendre conscience que l’IA pouvait avoir des conséquences éthiques différentes sur différents groupes de personnes. Le fait que les gens s’intéressent à cette question est prometteur. »

Le problème est mal posé.

Imaginons un conducteur humain. Il est surpris. Il n’a pas le temps de réfléchir. Que fait-il ? Une majorité va simplement freiner et percuter le bébé. Il n’y a pas de problème moral. Doit-on demander plus à un automatisme ?

Un automatisme conducteur se doit d’être un bon conducteur donc ne pas se retrouver dans ce cas. Si un automatisme conducteur se retrouve dans le même cas alors ce n’est pas le problème moral qu’il faut résoudre. Il faut revoir l’algorithme.

C’est la direction que prend l’aviation avec ses automatismes de pilotage. Les automatismes définissent un cadre duquel le pilote ne peut pas sortir. De même les automatismes de pilotage en croisière et à l’atterrissage.

Et que dit ChatGPT et autre soit disant intelligence artificielle ?

Comme le dit Promeneur plus haut, l’automatisme doit faire le nécessaire pour en pas se retrouver dans cette situation.

C’est d’ailleurs comme cela que fonctionne les automatismes dans le ferroviaire : le train ou le métro doit pouvoir s’arrêter dans la distance libre de tout obstacle. En aérien, le TCAS empêche les avions de s’approcher les uns des autres à moins d’une distance minimale.

C’est d’ailleurs ce qu’est censé faire un bon conducteur qui doit anticiper que la route n’est pas forcément dégagée à la sortie du virage, ou qu’un piéton peut surgir de derrière le véhicule stationné en bord de chaussée. Bon, ce n’est pas ce que font la majorité, mais c’est la règle qu’ils sont censés respecter.

Bonjour à tous et toutes,

Cette question de savoir qui doit être tué ne se poserait même pas si tout usager de la rue ou même de la route serait obligé de marquer l’arrêt, même une seconde, devant tout passage pour piétons. (Même si le feu est vert pour l’automobiliste ou le piéton)

L’intelligence artificielle devrait s’y conformer et adapter sa vitesse anticipativement pour éviter l’accident mortel et surtout faire en sorte que son véhicule marque l’arrêt devant tout passage pour piétons, selon l’obligation d’adapter sa vitesse à la situation réelle des lieux.

A votre service.

Danny

Bonjour,

Il me semble que demander à un système autonome de choisir entre tuer telle ou telle personne n’est pas la bonne question. La bonne question est beaucoup plus simple. Que faire s’il n’y a pas de bonne solution ?

La réponse l’est encore plus : freiner.

Cela mais tous le monde à égalité et supprime la question d’éthique pour laquelle il n’existe aucune bonne réponse

Le risque de faire une embardée en virant d’un côté est bien plus important et risqué, donc pas le choix, il faut freiner de face sans coup de volant. Je trouve très bien l’idée imposer l’arrêt à tout les passages piétons. Mais le mieux c’est PAS D’I.A. !